Материалы по тегу: южная корея

|

16.01.2026 [15:58], Руслан Авдеев

NTT Data проложит вместе с партнёрами 320-Тбит/с подводный интернет-кабель от Японии до Малайзии и СингапураЯпонская NTT Data возглавила кабельный проект, в котором также принимают участие Sumitomo Corporation и JA Mitsui Leasing. Совместное предприятие Intra-Asia Marine Networks намерено развернуть к 2029 году крупномасштабную подводную кабельную систему Intra-Asia Marine Cable (I-AM Cable) стоимостью порядка $1 млрд, связывающую Японию с другими ключевыми рынками региона, сообщает Converge Digest. I-AM Cable получит посадочные станции в Тибе (Chiba), Миэ (Mie) и Фукуоке (Fukuoka), а потом протянется от Японии до Малайзии и Сингапура с попутным заходом в Южную Корею, на Филиппины и Тайвань. Приоритет отдаётся «географической диверсификации» и устойчивости к землетрясениям и прочим природным катаклизмам. Кроме того, он должен укрепить роль Японии в качестве стратегического хаба, связывающего Азиатско-Тихоокеанский регион с глобальными информационными сетями. Фукуока и вовсе позиционируется как будущий хаб для международных телеком-маршрутом на фоне активной реализации в префектуре строительства новых дата-центров. Кабель длиной 8,1 тыс. км получит до 16 пар волокон (SDM), общая начальная пропускная способность составит 320 Тбит/с. Технология Wavelength Selective Switch (WSS) позволит операторам удалённо и динамически оптимизировать пропускную способность, отвечая на спрос облачных провайдеров, ИИ-платформ и телеком-операторов. I-AM NW будет управлять всем жизненным циклом системы, от планирования и прокладки до продажи международных каналов связи. Руководство I-AM NW заявляет, что проект станет важным этапом укрепления цифровой инфраструктуры Азии и станет основой создания надёжных и гибких решений, выступающих драйверами цифровых трансформаций в АТР. Рост рабочих ИИ-нагрузок и облачного трафика стимулирует инвестиции в подводные азиатские кабельные маршруты высокой пропускной способности. Это происходит несмотря на то, что задержки в строительстве ЦОД и бюрократические препятствия создают определённые препятствия. Крупномасштабные многомиллиардные кабельные системы всё чаще рассматриваются как долгосрочные капиталовложения, помогающие операторам управлять ростом, устойчивостью и рисками в регионе с высокой сейсмической активностью. Развитие кабельной инфраструктуре в регионе — вопрос важный. Ещё в июле 2025 года в докладе Cushman & Wakefield сообщалось, что Малайзия, Таиланд и Япония станут лидерами по росту ЦОД в АТР и кабельная инфраструктура им, очевидно, очень пригодится. Впрочем, новые кабели позволят максимально повысить эффективность и уже действующей инфраструктуры.

08.12.2025 [09:28], Руслан Авдеев

И запитать, и охладить: LG и LS сделали Microsoft пакетное предложение на инфраструктуру для ИИ ЦОД стоимостью миллиарды долларовТоп-менеджеры южнокорейских LG Group и LS Group посетили штаб-квартиру Microsoft в США для того, чтобы предложить всеобъемлющий план внедрения ИИ-инфраструктуры нового поколения. Это довольно редкий случай координации действий компаний на уровне высшего руководства для привлечения внимания одного из ключевых инвесторов в ИИ, сообщает The Korea Herald. Вместо того, чтобы предлагать отдельные продукты, южнокорейская делегация представила комплексную концепцию, направленную на решение двух главных проблем современных ЦОД — высокого тепловыделения и высокого энергопотребления. Вместо закупок компонетов по отдельности у компаний вроде Vertiv или Schneider Electric, в последнее время не готовых похвастаться малыми сроками поставок оборудования, Microsoft получила чрезвычайно выгодное пакетное предложение от вертикально интегрированных участников цепочки поставок. Для решения проблем с теплоотводом LG предложила передовые технологии терморегуляции вроде прямого жидкостного охлаждения чипов, системы иммерсионного охлаждения и чиллеры с центробежными компрессорами на магнитных подшипниках. Все эти решения направлены на оптимизацию использования энергии и улучшения коэффициента PUE. Ранее уже было объявлено о партнёрстве LG и Microsoft в вопросе охлаждения будущих ИИ ЦОД. LS предложила инфраструктурные решения, связанные непосредственно с подачей энергии, в том числе технологию шин, заменяющих громоздкие кабели для экономии места и снижения тепловыделения в условиях высокой плотности размещения оборудования в стойках, высоковольтные трансформаторы и системы подключения к энергосетям. LS включила в пакет предложений и аккумуляторные энергохранилища для сглаживания потребления в часы пиковых нагрузок. Хотя южнокорейские СМИ поспешили сообщить, что крупномасштабная сделка с Microsoft, стоимость которой оценивается в несколько миллиардов в год, уже подписана, участники делегации выпустили официальное уведомление о том, что окончательного соглашения ещё нет и дальнейшее взаимодействие продолжают обсуждать. Впрочем, присутствие топ-менеджеров двух крупных южнокорейских бизнес-групп в Редмонде уже свидетельствует о серьёзном настрое южнокорейского бизнеса позиционировать себя как инфраструктурного партнёра мирового уровня для ИИ-проектов. Стремление к унификации и объединения технологий прослеживается и среди других игроков рынка ЦОД. Так, в ноябре сообщалось, что NVIDIA ужесточит контроль над выпуском ИИ-платформ, задвинув Foxconn и других партнёров на второй план.

18.11.2025 [16:01], Руслан Авдеев

Samsung и Hyundai инвестируют $400 млрд в ИИ-проекты в Южной КорееКомпании Samsung и Hyundai объявили о масштабных инвестициях в размере $400 млрд в ИИ-проекты на территории Южной Кореи, сообщает Datacenter Dynamics. Анонс сделан вскоре после того, как США и Южная Корея договорились о торговой сделке, в рамках которой Южная Корея обязалась инвестировать $350 млрд в различные секторы американской экономики, в том числе полупроводниковую отрасль, энергетику и искусственный интеллект. На внутреннем рынке Samsung намерена инвестировать ₩450 трлн ($308 млрд). Значительная доля средств пойдёт на бизнес, связанный с ЦОД и производством полупроводников. В частности, к 2028 году будет построена пятая производственная линия на заводе в Пхёнтхэке (Pyeongtaek), где выпускаются чипы памяти HBM. Впрочем, практически ничего нового компания не сказала. О переносе строительства говорилось и ранее. Теперь компания добавила, что намерена вкладывать средства в обеспечение стабильного выпуска HBM. Также средства пойдут на строительство в Южной Корее производства для немецкой Flakt, выпускающей системы воздушного охлаждения, которую Samsung купила в начале ноября. Масштабы инвестиций особенно впечатляют, если учесть тяжёлый для выпускающей полупроводники «флагманской» дочерней структуры — Samsung Electronics. В III квартале наметились признаки восстановления бизнеса, и компания объявила о росте консолидированной выручки на 15,4 % квартал к кварталу, а также о рекордно высокой квартальной выручке подразделения, отвечающего за производство памяти. Тем не менее, ещё во II квартале компания столкнулась со значительным спадом, со снижением операционной прибыли на 94 % год к году.

Источник изображения: Yu Kato/unsplash.com Hyundai намерена инвестировать в отечественную экономику ₩125,2 трлн ($85 млрд) в течение пяти лет, начиная с 2026 года. При этом ₩50,5 трлн ($34,5 млрд) потратят на дата-центры, ИИ, электрификацию, робототехнику, водородные технологии и умный транспорт. Мощности ЦОД автопроизводителя будут использовать для обработки данных и эксплуатации ИИ, с особым упором на автономные транспортные средства и ИИ-роботов. По-видимому, именно об этом говорилось в соглашении с NVIDIA на поставку 50 тыс. ускорителей для создания ИИ-фабрики. Переговоры о тарифах между Южной Кореей и США оказались сложными. Президент США Дональд Трамп потребовал, чтобы Южная Корея вложила в экономику США $350 млрд. Депортация южнокорейских инженеров с аккумуляторного завода в США только подлила масла в огонь. Корейские власти заявили, что такой шаг поставит страну в положение, в котором она оказалась во время финансового кризиса 1997 года. Пока что американские пошлины на южнокорейские автомобили и автозапчасти снижены с 25 % до 15 %, а для полупроводников гарантируется режим не менее благоприятный, чем у других стран с развитой соответствующей отраслью.

01.11.2025 [01:07], Владимир Мироненко

NVIDIA продаст Южной Корее 260 тыс. ускорителей для создания суверенной ИИ-инфраструктуры

hardware

hyundai

kakao

lg

naver

nvidia

samsung

sk group

ии

медицина

производство

робототехника

сделка

суперкомпьютер

цифровой двойник

южная корея

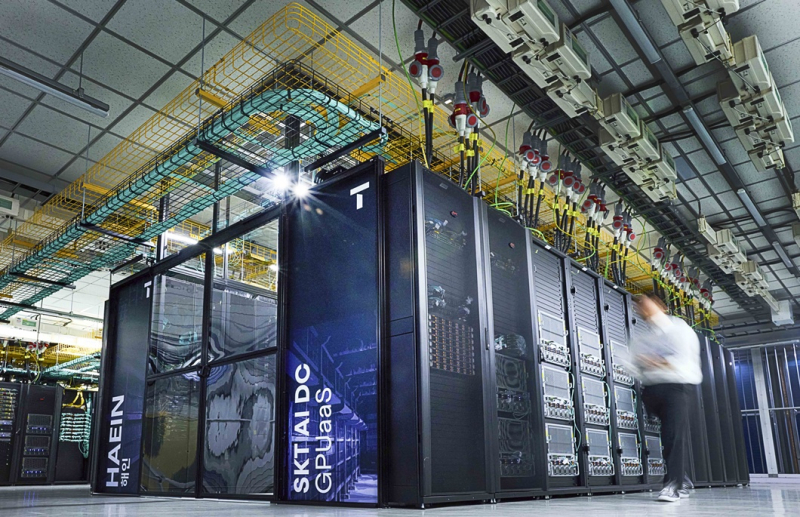

NVIDIA объявила на саммите АТЭС о стратегическом партнёрстве с рядом ведущих южнокорейских компаний и Министерством науки и ИКТ (MSIT) Южной Кореи, в рамках которого в стране будет развёрнута ИИ-инфраструктура с использованием 260 тыс. ИИ-ускорителей NVIDIA для поддержки суверенного ИИ, развития робототехники, производства и цифровой трансформации в различных отраслях. Как сообщается в пресс-релизе, масштабную инициативу поддержала коалиция крупнейших компаний Южной Кореи, включающая Samsung Electronics, SK Group, Hyundai Motor Group, NAVER Cloud, LG и т.д. Согласно соглашению, MSIT развернёт до 50 тыс. ускорителей NVIDIA у облачных провайдеров NHN Cloud, Kakao и NAVER Cloud, реализуя свою программу по созданию суверенной ИИ-инфраструктуры. На первом этапе буде установлено 13 тыс. ускорителей NVIDIA Blackwell с последующим наращиванием их количества в ближайшие годы. Samsung, SK Group и Hyundai Motor Group построят ИИ-фабрики, каждая из которых будет оснащена до 50 тыс. ускорителей NVIDIA; ещё 60 тыс. ускорителей развернёт NAVER. Samsung заявила, что использует ускорители NVIDIA для внедрения ИИ на всех этапах производства чипов, а также для разработки и проектирования микросхем, что позволит создать новое поколение полупроводников, мобильных устройств и робототехники с расширенными возможностями ИИ. Как сообщает SiliconANGLE, на планируемом Samsung заводе с «единой интеллектуальной сетью» ИИ будет непрерывно отслеживать и анализировать производственные условия, делать прогнозы, предоставлять информацию для технического обслуживания и оптимизировать все процессы для повышения производительности производства микросхем. Для этого компания будет активно использовать цифровых двойников на базе ИИ, или виртуальные копии своих микросхем, созданные с помощью NVIDIA CUDA-X, cuLitho, моделей Nemotron, а также Omniverse. Используя платформу NVIDIA Omniverse, компания создаст цифровые двойники каждого компонента, используемого в полупроводниках, включая память, логику, современную компоновку и т.д. Также компания планирует создать цифровых двойников своих производственных предприятий и дорогостоящего оборудования, что позволит моделировать процессы производства чипов в виртуальной среде, где она сможет проверить их работу до запуска реальных производственных линий. Это позволит выявлять отклонения и определять, где необходимо профилактическое обслуживание, как оптимизировать производство и многое другое, а затем применять полученные знания на своем реальном заводе. В свою очередь, SK Group разрабатывает ИИ-фабрику на базе до 60 тыс. ускорителей NVIDIA, включая ИИ-облако на базе ускорителей RTX PRO 6000 Blackwell Server Edition. После ввода в эксплуатацию (завершение заключительного этапа ожидается в конце 2027 года) она станет одной из крупнейших в стране ИИ-фабрик, которая будет обслуживать дочерние компании SK, включая SK Hynix и SK Telecom, а также внешние организации по модели GPUaaS. Сообщается, что SK Telecom предоставит отечественным производителям и стартапам суверенную инфраструктуру для создания цифровых двойников и ИИ-агентов, а также приложений для робототехники. Какие именно ускорители NVIDIA будут использовать Samsung и SK Group, пока не уточняется. Hyundai Motor Group сообщила, что совместно с MSIT и NVIDIA создаёт ИИ-фабрику с 50 тыс. ускорителей NVIDIA Blackwell, которая обеспечит обучение, валидацию и развёртывание ИИ-моделей для производства, автономного вождения и робототехники. Компания планирует использовать NVIDIA DRIVE AGX Thor, NeMo, Nemotron и Omniverse для моделирования заводских процессов. Партнёрство будет способствовать созданию Центра ИИ-приложений и Центра ИИ-технологий. Компания также заявила, что построит суперкомпьютер, пишет Data Center Dynamics. Компания NAVER добавит 60 тыс. ускорителей в свою инфраструктуру NVIDIA AI, ориентируясь на задачи суверенного и физического ИИ. Компания планирует разрабатываать отраслевые модели для судостроения, безопасности и услуг в сфере ИИ для граждан Южной Кореи. Также сообщается, что MSIT возглавляет проект Sovereign AI Foundation Models в сотрудничестве с LG AI Research, NAVER Cloud, NC AI, SK Telecom, Upstage и NVIDIA. В его реализации будут использоваться ПО NVIDIA NeMo и открытые наборы данных NVIDIA Nemotron, что позволит использовать локальные данные для разработки моделей с поддержкой корейского языка с функциями рассуждения и речи. NVIDIA и LG сотрудничают в поддержке академических кругов и стартапов, используя модели LG EXAONE, включая модель EXAONE Path в сфере здравоохранения для диагностики рака, созданную на основе фреймворка MONAI. Компания также сотрудничает с NVIDIA в поддержке стартапов в области физического ИИ и академических исследований. В свою очередь, Корейский институт научно-технической информации (KISTI) сотрудничает с NVIDIA с целью создания Центра передового опыта в области квантовых вычислений и научных исследований. Используя свой суперкомпьютер HANGANG шестого поколения и платформу NVIDIA CUDA-Q, KISTI будет изучать гибридные квантовые вычисления, физически информированные ИИ-модели (physics-informed AI models) и базовые SF-модели (Scientific Foundation Models), созданные с помощью фреймворка NVIDIA PhysicsNeMo.

30.10.2025 [16:56], Руслан Авдеев

AWS инвестирует не менее $5 млрд в ЦОД Южной КореиПо данным администрации президента Южной Кореи, Amazon Web Services (AWS) инвестирует в страну как минимум $5 млрд. Средства будут потрачены на новые ИИ ЦОД — Сеул намерен стать одним из ключевых ИИ-хабов в Азии, сообщает Reuters. Объявление было сделано в ходе встречи генерального директора AWS Мэтта Гармана (Matt Garman) с президентом Южной Кореи Ли Чжэ Мёном (Lee Jae Myung) на полях саммита Азиатско-Тихоокеанского экономического сотрудничества (АТЭС). Amazon является одной из семи компаний глобального уровня, чьи лидеры посетили групповую встречу с Ли и пообещали инвестировать в страну $9 млрд в следующие пять лет. Как заявил президент, инвестиции Amazon ускорят рост экосистемы для ИИ-индустрии в Южной Корее, поскольку страна намерена войти в тройку лидеров в сфере ИИ. Гарман в ответ подчеркнул, что что его компания уже инвестировала и намерена инвестировать дополнительные $40 млрд в 14 страны Азиатско-Тихоокеанского региона (АТР) до 2028 года. При этом такие инвестиции обеспечат экономике США $45 млрд. В июне AWS представила план инвестиций $4 млрд в Южную Корею в рамках проекта SK Group по строительству крупнейшего в стране дата-центра в Ульсане (Ulsan). Также анонсированы инвестиции в другие страны региона, включая Японию, Австралию и Сингапур. Ранее в этом месяце сообщалось, что OpenAI намеревалась открыть в Южной Корее совместные предприятия с Samsung и SK для строительства двух ЦОД, корейского вариант Stargate с изначальной мощностью 20 МВт. OpenAI заявила, что Южная Корея — один из рекордсменов по числу подписчиков GhatGPT, в этом отношении она уступает только США. Также OpenAI заключила сделки для приобретения чипов памяти для своих дата-центров у Samsung Electronics и SK Hynix.

12.10.2025 [15:22], Руслан Авдеев

Арест за арестом: причиной возгорания в правительственном ЦОД Южной Кореи могло стать не отключенное вовремя резервное питаниеПолиция Южной Кореи полагает, что причиной крупного пожара в ЦОД Национальной службы информационных ресурсов (NIRS) 26 сентября, который привёл к отключению около 700 государственных сервисов и потери 858 Тбайт данных, могло стать некорректное отключение питания перед проведением технического обслуживания литий-ионных батарей. Перед переносом АКБ была отключена основная линия питания, однако вспомогательная, как выяснилось, продолжала работу. Аресты предполагаемых виновных продолжаются, сообщает Datacenter Dynamics. На прошлой неделе полиция арестовала четырёх человек по подозрению в халатности. Представители правоохранительных органов заявляют, что допрошено уже 26 человек, четверо было арестовано, а недавно арестовали пятого. Также проведены обыски в NIRS и трёх компаниях-партнёрах центра, конфискованы различные материалы, в т.ч. проектная документация и журналы работы аккумуляторов. Свидетели говорят, что основное электропитание было отключено примерно за час до начала пожара, однако вспомогательное питание всё ещё работало. Непосредственно возгорание произошло при попытке перемещения одного из аккумуляторов из зала на пятом этаже в подвал, что потребовало отключения силовых кабелей. Не исключено, что именно поэтому загоревшаяся батарея была заряжена на 80–90 %, тогда как многие производители рекомендуют низкий и средний уровень заряда перед перемещением литий-ионных модулей. Представители полиции ссылаются на мнение экспертов, уверенных, что потенциальный ущерб от пожара тем больше, чем выше заряд аккумуляторов. Аккумуляторы ЦОД разберут для дальнейшего изучения, также эксперты проведут эксперименты с идентичными моделями для выяснения причин возгорания. Пожар уничтожил 384 аккумуляторных модулей и 740 единиц IT-оборудования. По состоянию на минувшую пятницу было восстановлено 217 государственных систем — менее трети от общего числа. Считается, что операторы правительственной системы G-Drive, содержавшей 858 Тбайт информации, потеряли её безвозвратно, поскольку резервных копий не существовало. Примечательно, что спустя несколько дней в том же городе случился ещё один пожар, на этот раз в ЦОД Lotte Innovate. Причиной снова названо возгорание ИБП, причём буквально на следующий день после инспекции пожарной службы.

07.10.2025 [00:50], Владимир Мироненко

Бэкапов нет, работа стоит, надежд мало: 858 Тбайт правительственных данных безвозвратно утеряны из-за пожара в ЦОД в Южной КорееВ Южной Корее продолжаются восстановительные работы в ЦОД Национальной службы информационных ресурсов (NIRS) Южной Кореи в Тэджоне, где 26 сентября произошёл масштабный пожар, который привёл к сбою в работе 647 государственных сервисов, пишет газета The Korea JoongAng Daily. В результате пожара утеряно множество важных данных, для которых не делались бэкапы, так что некоторые подразделения теперь вынуждены по крупицам собирать сохранившуюся информацию. Как стало известно, из-за пожара было уничтожено правительственное облачное хранилище G-Drive (никак не связано с Google). Утеряно 858 Тбайт данных примерно 750 тыс. госслужащих. Платформа является обязательной для хранения документов и других файлов госслужащих. Каждому сотруднику на эти цели было выделно порядка 30 Гбайт пространства. По словам NIRS, из-за большой ёмкости и низкой производительности системы внешние резервные копии не создавались, что привело к безвозвратной потере данных. В Министерстве внутренних дел и безопасности Южной Кореи пояснили, что структура G-Drive не позволяет создавать внешние резервные копии, хотя данные большинства систем подлежат резервному копированию в хранилище в этом же ЦОД и на ещё одном физически удалённом объекте. В свою очередь, Data Center Dynamics со ссылкой южнокорейские СМИ сообщил, что G-Drive была одной из 96 полностью уничтоженных в результате пожара систем. Вместе с тем, у остальных 95 систем сохранились резервные копии данных в онлайн- или офлайн-форматах. Некоторые департаменты не пользовались G-Drive, но те, кто использовал, столкнулись с серьёзными проблемами. Сильнее всего пострадало Министерство управления персоналом, издавшее распоряжение хранить всю документацию исключительно на G-Drive. Сейчас оно собирает все оставшиеся на ПК чиновников файлы, а также почтовые сообщения, официальные документы и даже распечатки. Министерство внутренних дел и безопасности Южной Кореи отметило, что официальная отчётность также хранится в правительственной системе OnNara и может быть восстановлена после возобновления её работы. «Заключительные отчёты и официальные документы, представленные правительству, также хранятся в OnNara, поэтому это не полная потеря данных», — заявил директор по государственным услугам Министерства внутренних дел и безопасности Южной Кореи. К прошедшим выходным удалось восстановить лишь 115 из 647 пострадавших сервисов. Ожидается, что полное восстановление займёт около месяца. Правительство заявило, что будут предложены альтернативные варианты на замену наиболее важных сервисов.

04.10.2025 [00:38], Владимир Мироненко

В южнокорейском Тэджоне загорелся уже второй ЦОД за неделю, сразу после инспекции пожарных — виноватым снова назначили ИБПСпустя несколько дней после масштабного пожара в дата-центре национального информационно-ресурсного агентства Южной Кореи (NIRS) в Тэджоне (Daejeon), который вызвал сбой в работе 647 государственных сервисов, ещё в одном ЦОД этого города произошёл пожар, сообщает газета The Korea JoongAng Daily. На этот раз возгорание произошло в дата-центре корейского провайдера Lotte Innovate около 4:59 утра в четверг. Пожарная служба города направила на место происшествия 21 единицу техники и 62 человека личного состава, и к 5:38 утра пожар был потушен. Пострадавших нет, сообщила газета. Под управлением Lotte Innovate находятся четыре ЦОД в Южной Корее. Дата-центр в Тэджоне был введён в эксплуатацию в 2010 году. Согласно предварительной версии, возгорание произошло в модуле источника бесперебойного питания (ИБП) в машинном зале на первом этаже двухэтажного здания. Предполагается, что причиной возгорания могла стать некондиционная батарея, но окончательные выводы будут сделаны после завершения расследования соответствующих органов.

Источник изображения: Max Kukurudziak/unsplash.com Второй пожар в ЦОД менее чем за неделю поставил под сомнение эффективность недавних проверок безопасности ЦОД. После пожара в дата-центре NIRS полиция арестовала четырёх человек, а власти и пожарная служба провели экстренные проверки в пяти крупных местных ЦОД, включая и дата-центр Lotte Innovate, где буквально на следующий день после инспекции произошло возгорание. Как сообщает The Korea JoongAng Daily, полиция и пожарная служба планируют допросить сотрудников Lotte Innovate, чтобы установить точную причину пожара и оценить масштаб ущерба.

01.10.2025 [18:15], Руслан Авдеев

OpenAI построит ИИ ЦОД Stargate в Южной Корее, а Samsung поможет ей создать плавучие дата-центрыOpenAI подписала с Samsung Electronics и SK hynix письмо о намерениях, предусматривающее поставку чипов памяти знаменитому ИИ-стартапу. Дополнительно сообщается о намерении построить ЦОД Stargate на юго-западе Южной Кореи при участии SK Group. Кроме того, SK Telecom создаёт независимую ИИ-компанию с инвестициями $3,5 млрд в течение пяти лет. В рамках сотрудничества южнокорейские компании планируют нарастить выпуск DRAM — до 900 тыс. пластин в месяц, которые понадобятся для передовых моделей OpenAI. Samsung и её дочерние структуры Samsung SDS, Samsung C&T (Construction and Trading) и Samsung Heavy Industries помогут в реализации проекта Stargate Korea, в том числе со строительством и эксплуатацией ЦОД, облачными сервисами, консалтингом, а также внедрением и управлением сервисами для бизнесов, желающих интегрировать ИИ-модели OpenAI в свои внутренние системы. Упоминаются даже судостроение и морское дело. В частности, сотрудничество предусматривает совместную разработку плавучих ЦОД. Подобные объекты имеют определённые преимущества перед традиционными, поскольку им не требуется свободных участков земли, лишних расходов на охлаждение и углеродные выбросы таких проектов обычно невелики. Компании также изучают возможности создания плавучих электростанций и центров управления.

Источник изображения: Mathew Schwartz/unsplash.com Проект Stargate был запущен OpenAI в январе, при содействии Oracle, SoftBank, и MGX из Абу-Даби и уже заработали его первые ЦОД. Планируется инвестировать $500 млрд в цифровую инфраструктуру в следующие четыре года для обслуживания вычислительных потребностей OpenAI. На прошлой неделе OpenAI анонсировала строительство новых ЦОД Stargate в США, включая дата-центры в Техасе, Нью-Мексико и на Среднем Западе. Планируется реализация проектов Stargate и в других странах помимо Южной Кореи, например — в Великобритании и Норвегии.

01.10.2025 [11:51], Сергей Карасёв

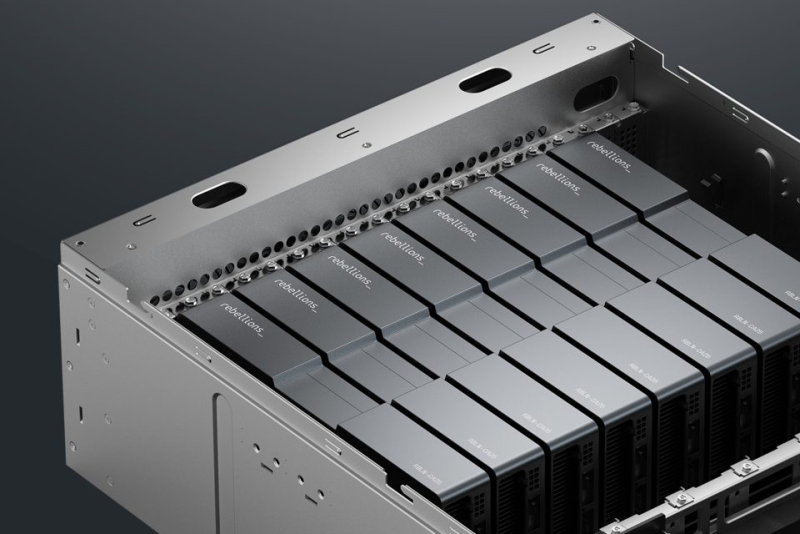

ИИ-стартап Rebellions привлёк финансирование от Arm и Samsung, получив оценку в $1,4 млрдЮжнокорейский разработчик ИИ-чипов Rebellions, по сообщению Datacenter Dynamics, провёл раунд финансирования Series C, в ходе которого на развитие привлечено $250 млн. В число инвесторов вошли Arm и Samsung Ventures. В результате стартап получил оценку на уровне $1,4 млрд. Фирма Rebellions, основанная в 2020 году, создаёт ускорители для ИИ-инференса, которые обеспечивают энергоэффективность и высокую производительность при небольших задержках. В 2023 году Rebellions начала массовое производство серверных ускорителей Atom и Atom Max для запуска больших языковых моделей (LLM) в дата-центрах. А в мае нынешнего года стартап представил ускоритель Rebel-Quad, оснащённый 144 Гбайт памяти HBM3e с пропускной способностью до 4,8 Тбайт/с. Это изделие, как утверждается, обеспечивает ИИ-производительность до 1 Пфлопс в режиме FP16 и до 2 Пфлопс на операциях FP8. Устройство выполнено в виде карты расширения с интерфейсом PCIe 5.0 x16. Заявленное энергопотребление — до 600 Вт. Rebellions отмечает, что по эффективности (количеству транзакций на 1 Вт затрачиваемой энергии) ускоритель Rebel-Quad приблизительно в 3,2 раза превосходит изделие NVIDIA H200. В инвестиционном раунде Series C, помимо Arm и Samsung Ventures, приняли участие Korea Development Bank и Korelya Capital. Полученные средства будут направлены в том числе на организацию массового производства Rebel-Quad, а также на укрепление позиций на рынках США, Европы и Азиатско-Тихоокеанского региона. По заявлениям Rebellions, её решения уже применяются клиентами в Японии, Саудовской Аравии и США. Нужно отметить, что в январе 2024 года Rebellions осуществила раунд финансирования Series B, в ходе которого было получено $124 млн. Позднее компания привлекла $15 млн от Wa’ed Ventures, венчурного подразделения саудовского нефтегазового и химического гиганта Aramco. А в июне 2024-го стартап объявил о слиянии с разработчиком ИИ-чипов Sapeon Korea, который был выделен из SK Telecom в 2016 году. |

|